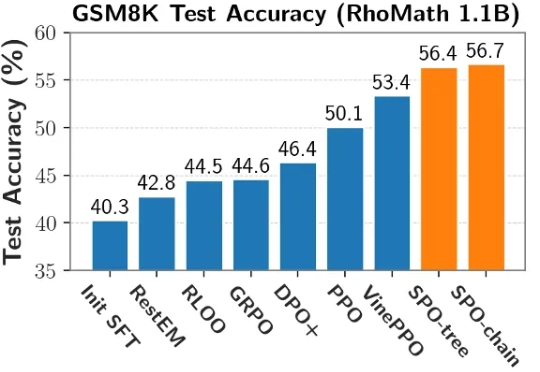

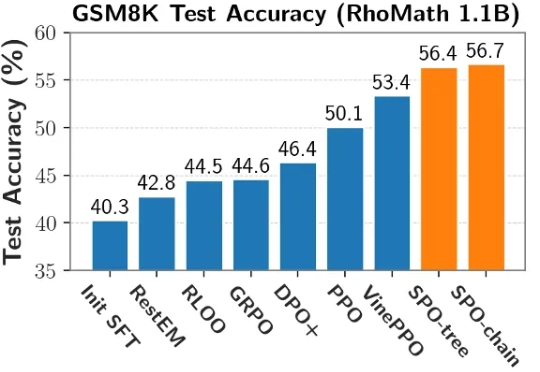

大模型强化学习新突破——SPO新范式助力大模型推理能力提升!

大模型强化学习新突破——SPO新范式助力大模型推理能力提升!当前,强化学习(RL)在提升大语言模型(LLM)推理能力方面展现出巨大潜力。DeepSeek R1、Kimi K1.5 和 Qwen 3 等模型充分证明了 RL 在增强 LLM 复杂推理能力方面的有效性。

当前,强化学习(RL)在提升大语言模型(LLM)推理能力方面展现出巨大潜力。DeepSeek R1、Kimi K1.5 和 Qwen 3 等模型充分证明了 RL 在增强 LLM 复杂推理能力方面的有效性。

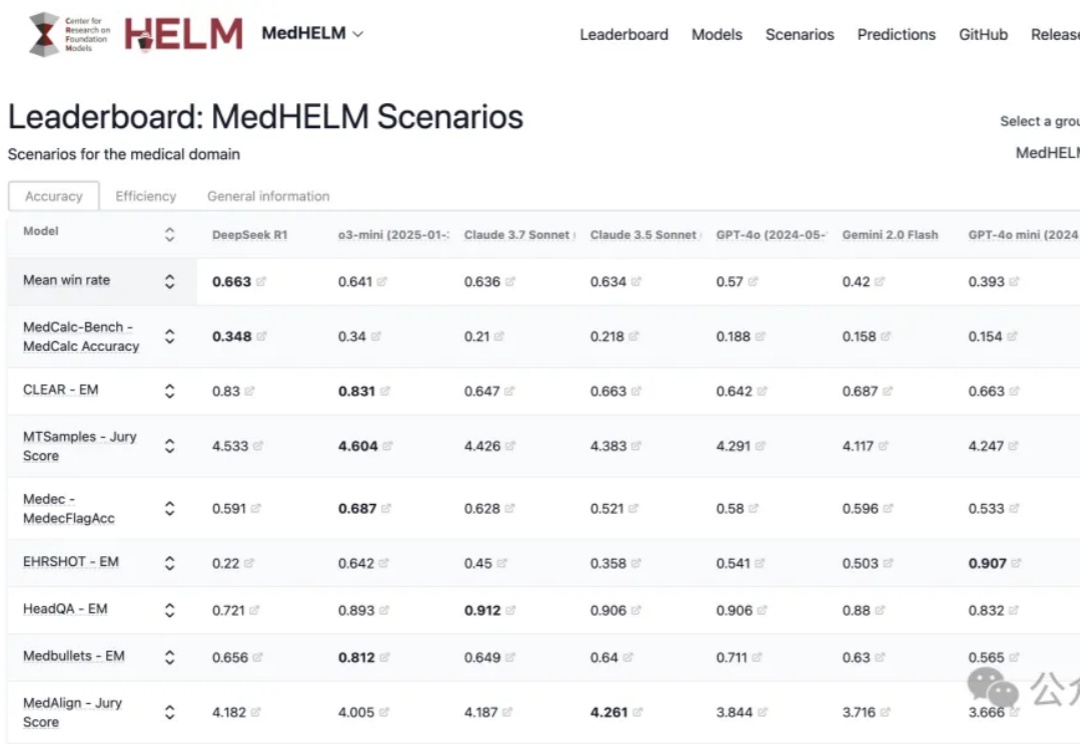

斯坦福最新大模型医疗任务全面评测,DeepSeek R1以66%胜率拿下第一!

MiniMax即将发布代号M+的文本推理模型,其表现将影响公司未来竞争力。面对DeepSeek R1的冲击,MiniMax采取国内C端不接入、海外接入的策略,并推出类Manus产品MiniMax Agent。公司通过品牌拆分(海螺AI更名)、纯API商业模式拓展市场,语音模型商业化效果显著,但未进入“基模五强”名单。新推理模型或成其保持行业地位的关键。

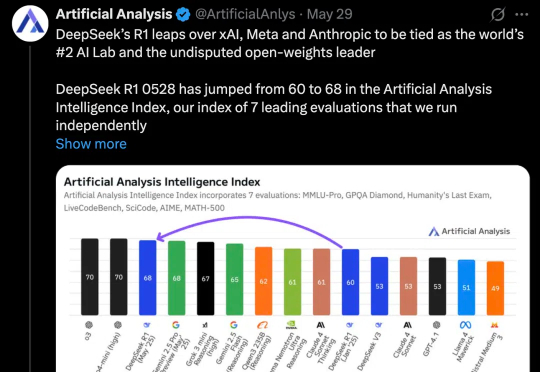

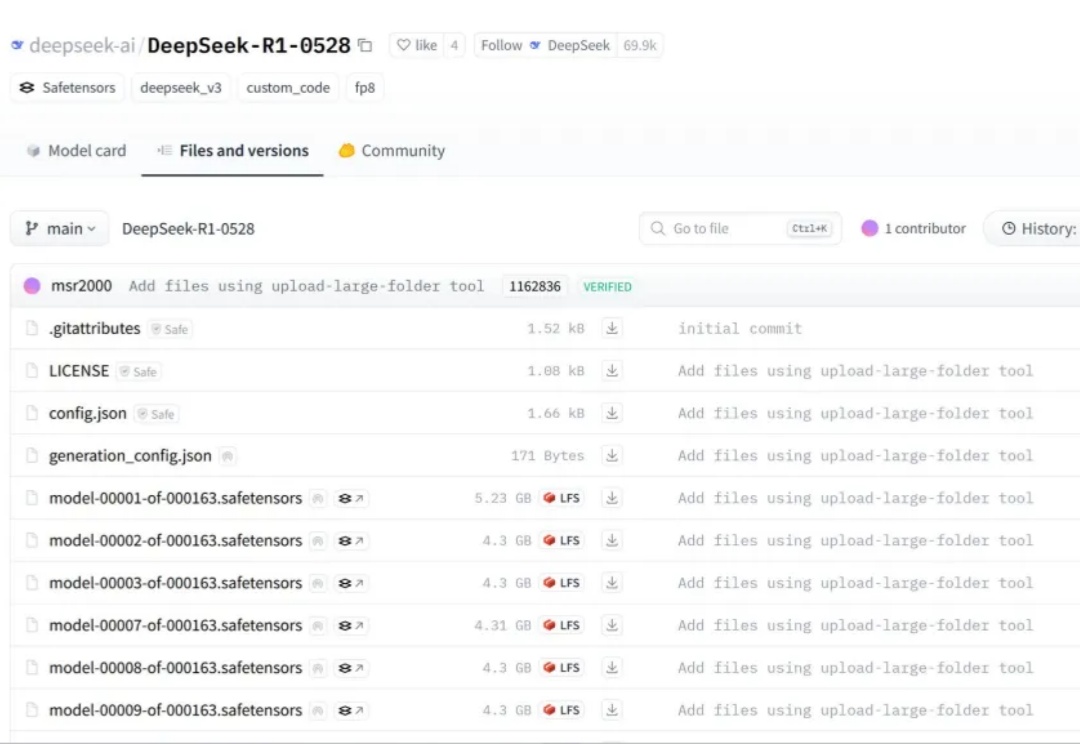

几天前,没有预热,没有发布会,DeepSeek 低调上传了 DeepSeek R1(0528)的更新。

DeepSeek 猝不及防地更新了,不是 R2,而是 R1 v2。

哈喽,大家好,我是袋鼠帝 昨天下午下班后,DeepSeek R1更新了 然而他们就只是悄悄在微信群里面发布了这个消息。

近半年来,OpenAI 形象开始变得灰暗: 团队骨干相继离职引发猜疑、组织转型遭受口诛笔伐、GPT-4.5/Sora 等模型表现不及预期,还有被 DeepSeek R1 打破的叙事神话……

在今年,DeepSeek R1火了之后。

英伟达官宣新办公室落户中国台湾省台北市,但居然是从太空飞下来的吗?

这组充满悬念的组合引发科技圈热议,业内普遍推测DeepSeek R2模型已进入发布倒计时。凤凰网科技从知情人士处获悉,目前网传信息的真实性含量很低。